10808

10808 10808

10808Google представил новые мультимодальные ИИ-модели, которые специализируется на медицинских данных. Это самые функциональные открытые модели компании для разработчиков в сфере здравоохранения. Новость опубликовали в блоге Google 9 июля 2025 года.

Здравоохранение активно внедряет искусственный интеллект (ИИ), чтобы улучшить управление рабочими процессами, коммуникацию с пациентами, диагностику и лечение. Поэтому Google создают и выпускают ИИ-модели, специально обученные на обширных медицинских данных. Такие нейросети глубже понимают специфику медико-биологических наук, чем универсальные языковые модели.

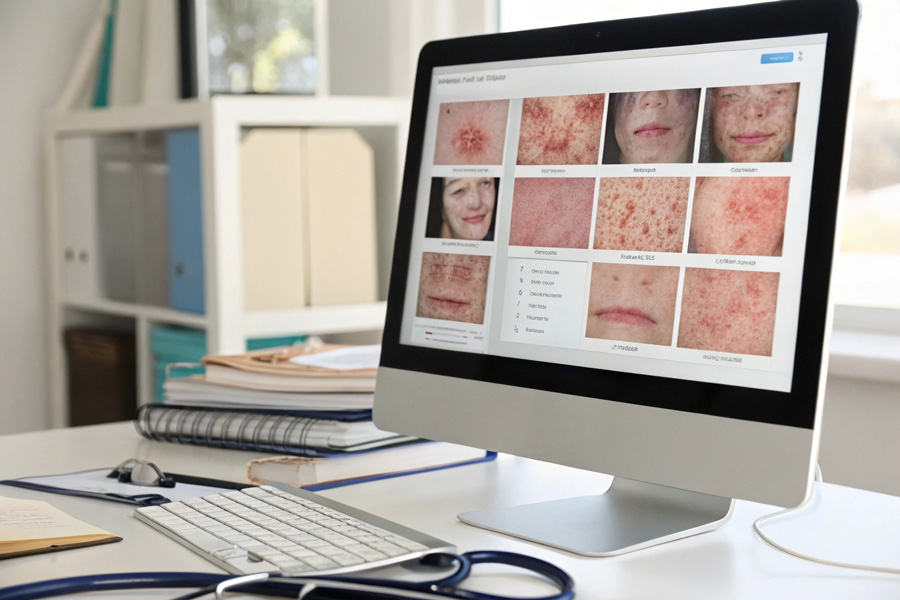

Google 9 июля представил две новые конкретные медицинские языковые модели — MedGemma 27B Multimodal и MedSigLIP. Первая работает преимущественно с текстом, вторая — с изображениями.

MedGemma 27B Multimodal — это большая языковая модель (LLM), специально обученная на текстах из 22 медицинских баз и более чем 500 тысячах медицинских изображений. Модель понимает сложную медицинскую терминологию и концепцию принятия клинических решений гораздо лучше, чем универсальные языковые модели. Нейросети можно скидывать изображения и писать текст, но ответы она выдает только в виде текста.

Что может MedGemma 27B Multimodal:

MedGemma 27B Multimodal — одна из самых эффективных небольших открытых ИИ-моделей в сфере медицины. В тесте MedQA она набрала 87,7%, что на 3 балла меньше, чем у передовой DeepSeek R1. Напомним, что MedQA — это база с десятками тысяч медицинских вопросов с несколькими вариантами ответа. Тесты на трех языках взяли из экзамена для врачей в США, который сдают для получения медицинской лицензии.

MedSigLIP — это специализированный кодировщик изображений для сферы здравоохранений, который состоит из 400 млн параментров. Это мультимодальная модель, которая способная понимать и связывать информацию из медицинских изображений и соответствующего им текста. Она распознает в том числе и рентгеновские снимки грудной клетки, гистопатологические срезы, срезы томограмм КТ и МРТ, фотографии кожи и глазного дна, а также соответствующие описания или отчеты.

Что может MedSigLIP:

Обе новые модели можно скачивать, дорабатывать и настраивать под нужды разработчиков. А это значит, что в будущем будет еще больше устройств и приложений с ИИ в медицинской сфере.